Appearance

Basic

信息消息信号

信息的度量:信息量

信息量定义:对发生概率为

抛硬币:

简单说,对于bit由于只有01两种状态,故对于一个概率为1/2的事件,其信息量为1bit,而对于概率为1的事件,其信息量为0bit,

信息量与熵

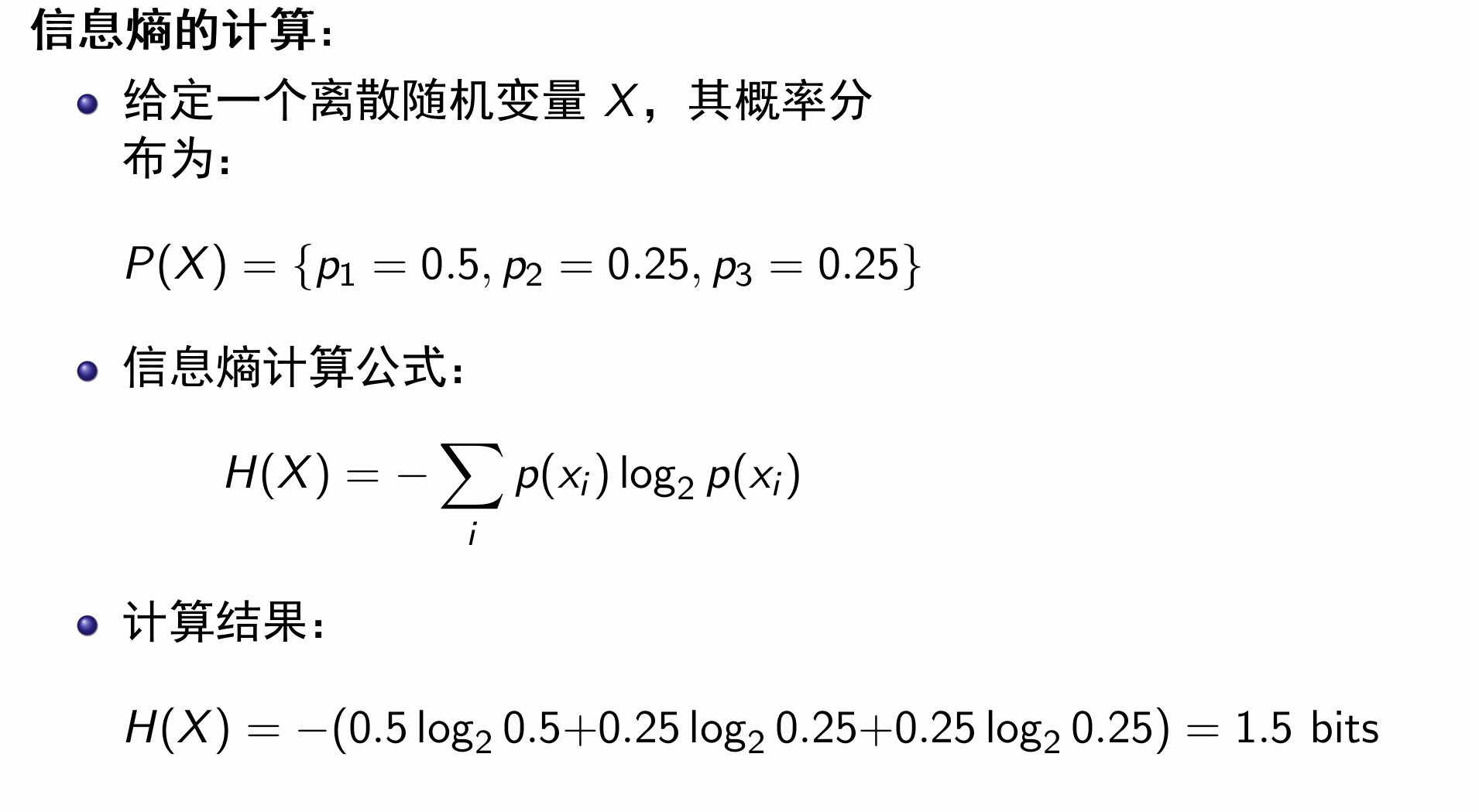

熵:平均信息量

定义

设概率为

如果是确定性事件

离散变量计算:

e.g.:抛硬币:

e.g.2:

e.g.3:

设有千字文,每一字从万字表中选,求一篇的信息量:

总共有:

信息量为:

信源

对于一个二元信源:

如果横轴是概率

对于一个n元信源,熵取值范围为

而对于一个加密算法而言,熵越大,破解难度越大。假设有一个映射

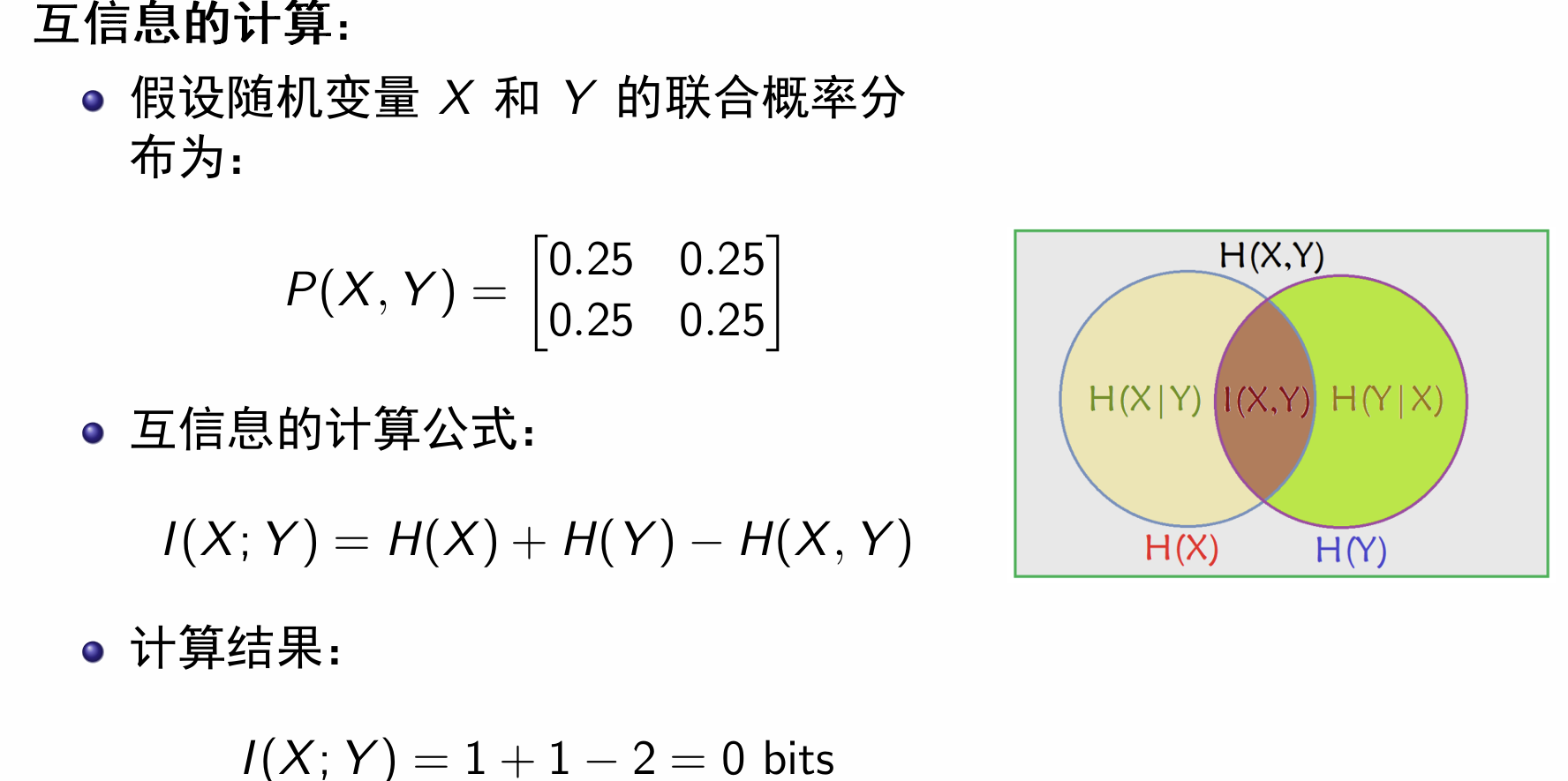

联合熵

表示

e.g.:

条件熵

表示在已知

可用以下公式计算:

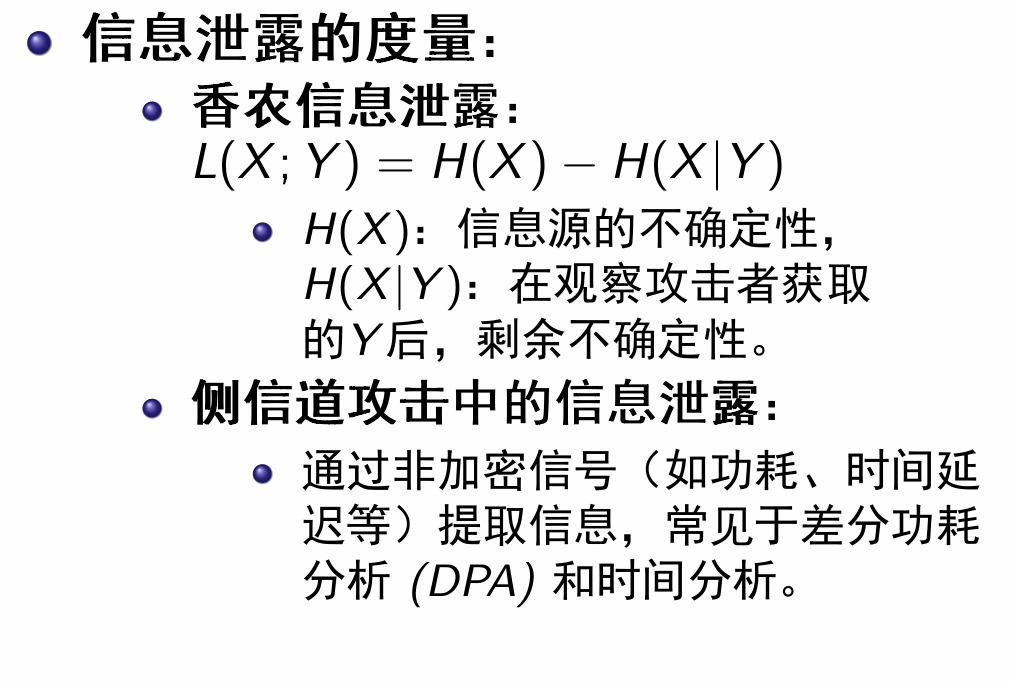

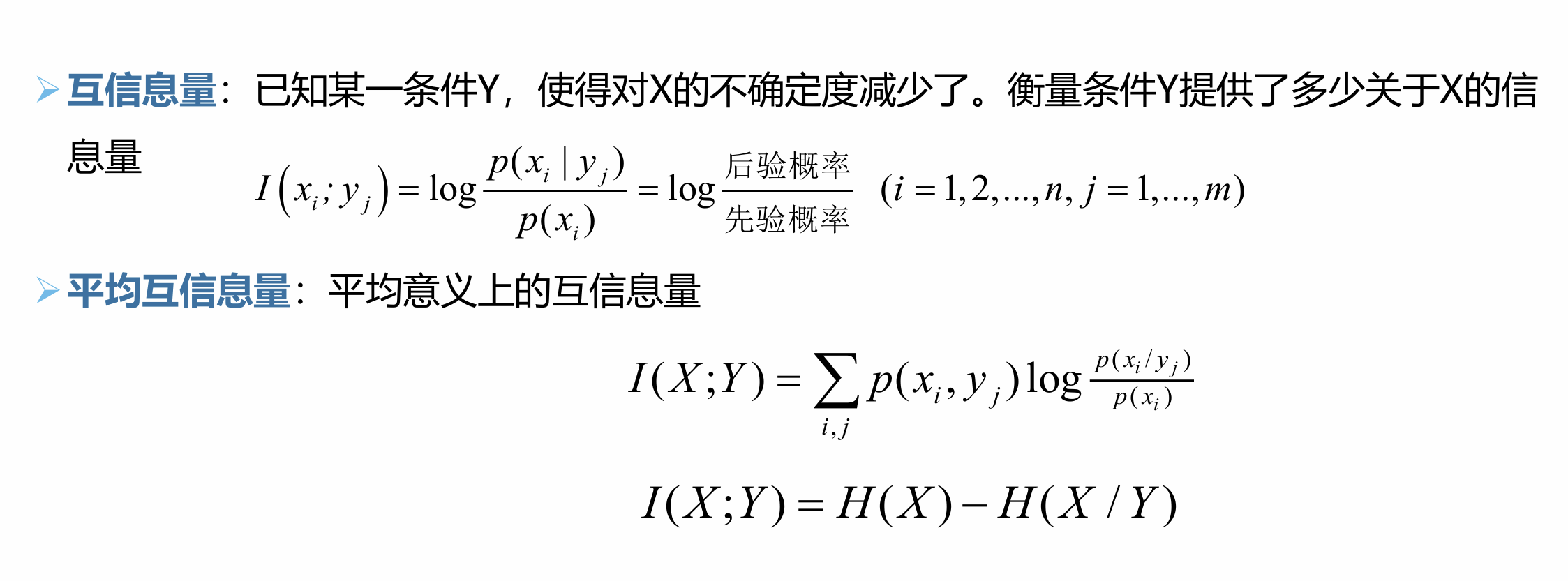

互信息

定义:

推导有:

信源编码

作用:信息压缩

香农第一定律

其中

信源编码定理

设信源